REUNICA réduit ses coûts d’administration et gagne en souplesse de travail

Groupe de protection sociale, Réunica rassemble des activités de mutuelle, de prévoyance et de retraite. Afin de réduire ses coûts, la société a choisi de consolider ses serveurs destinés aux tests et à la validation des applications qu’elle a développées en s’appuyant sur Microsoft Virtual Server 2005. Très satisfaite des gains réalisés en matériel et en administration, Réunica n’a pas hésité à étendre son expérience à ses serveurs métiers.« Au fil du temps, les serveurs destinés aux environnements d’étude, de développement, de recette ou de pré production se sont multipliés, raconte Jean- Francois Neron, responsable systèmes et réseaux de Réunica. Nous avions autant de machines physiques que d’instances de Windows, ce qui coûte cher en matériel mais également en maintenance ». Début 2004, dans le cadre du programme RAP (Rapid Adoption Programm) qui permet aux entreprises de tester les solutions de Microsoft en phase bêta, Réunica a donc procédé à une étude qui l’a conduite vers Virtual Server 2005 de Microsoft. Cette solution de virtualisation sous Windows Server 2003 permet à Réunica de consolider ses serveurs de préproduction, de créer toutes les instances de Windows nécessaires à ses projets de tests, d’installation de nouveaux produits ou de déploiement d’applications. Avec, à la clé, une réduction significative des coûts et des gains de temps importants consacré à l’administration des environnements de travail.

De fait, grâce à cette évolution, la société a pu ramener ses serveurs au nombre de dix sans investir dans du nouveau matériel en lieu et place de la quarantaine de serveurs physiques. Très satisfaite des économies réalisées en maintenance, mais aussi de sa plus grande souplesse de travail, Réunica a également choisi de déployer Virtual Server 2005 en production pour consolider des serveurs hébergeant des applications métiers.

Autoruns

Pourquoi la connexion prend-elle autant de temps ? Que sont toutes ces icônes dans le plateau système ? Comment empêcher les programmes de démarrer automatiquement? Comment me débarrasser de cette étrange erreur qui apparaît sans cesse pendant le logon ? Vous avez probablement entendu souvent ces questions, particulièrement de la part d’utilisateurs Windows travaillant sur de nouveaux systèmes pleins d’applications préchargées ou sur des systèmes plus anciens sur lesquels ils ont installé de nombreux programmes au fil du temps. Ce mois-ci, je vais cesser d’écrire à propos des outils de la suite Sysinternals PsTools pour vous entretenir d’un outil, capable de répondre à ces questions : Systinternals Autoruns.A l’installation, beaucoup d’applications se configurent de manière à démarrer automatiquement quand vous vous connectez. Les applications font cela afin de consulter automatiquement les mises à jour, parce qu’elles utilisent les icônes du plateau système pour interagir avec les utilisateurs, ou parce qu’elles ajoutent de la fonctionnalité aux composants Windows, comme Windows Explorer.

Malheureusement, beaucoup de ces applications ne demandent aucune permission avant de s’insérer dans votre processus de connexion et n’offrent presque jamais une interface vous permettant de désactiver leur autodémarrage.

Windows Server 2003 et Windows XP incluent l’utilitaire System Configuration (Msconfig.exe) qui est fondé sur un outil similaire dans Windows Me. Msconfig possède un onglet Startup qui donne la liste, et vous permet de désactiver, certains éléments qui s’exécutent automatiquement dès que vous vous connectez. Mais Msconfig présente deux limitations importantes : il n’affiche des éléments qu’à partir d’une fraction des endroits dans lesquels les applications à autodémarrage peuvent se cacher et il ne donne que peu d’informations sur les éléments qui figurent dans sa liste. De plus, si vous utilisez Windows 2000 ou Windows NT 4.0, vous n’avez pas de chance. Aucun de ces OS ne contient Msconfig ou d’autres outils intégrés pour présenter les composants qui s’exécutent automatiquement au moment de la connexion.

Vous pouvez utiliser Autoruns, qu’illustre la figure 1, non seulement pour identifier les applications qui se sont configurées elles-mêmes pour démarrer au logon, mais aussi pour voir tous les endroits où les applications à autodémarrage pourraient configurées sur le système. Autoruns fonctionne sur toutes les versions de Windows, y compris Windows Me et Windows 9x. Vous pouvez télécharger l’outil à http://www. sysinternals.com.

La gestion simultanée des environnements Windows et UNIX coûte-t-elle cher à votre entreprise ?

Réduisez vos coûts et utilisez la puissance d'UNIX - avec Secure Shell, scp, sftp, secure X, Kornshell, CShell, awk. telnet server, xterm, rsh, rlogin et plus de 400 commandes et utilitaires additionnels pour gérer votre environnement Windows avec la puissance des outils UNIX. Tous les produits MKS Toolkit sont entièrement supportés et disponibles aussi bien pour les systèmes Windows 64-bit que les systèmes Windows 32-bit. Utilisez l'expertise de vos Développeurs et vos Administarteurs Système à la fois sur Windows et UNIX.

Lire l'article

Microsoft Virtual Server 2005 ou la virtualisation des ressources serveurs

Lancé courant octobre 2004, Microsoft Virtual Server 2005 est la solution de virtualisation des ressources serveurs de Microsoft. Virtual Server fait partie intégrante de l’initiative Dynamic Systems Initiative – effort de Microsoft visant à l’amélioration du management des systèmes d’information. Virtual Server est destiné à simplifier et à automatiser la gestion des systèmes d’exploitation et des applications. Virtual Server apporte une flexibilité et une convivialité dans la gestion des machines virtuelles tout en proposant de solides fonctionnalités de stockage. La technologie utilisée est la même que pour Virtual PC, avec quelques améliorations spécifiques afin de mieux supporter les applications serveur.Les trois principaux scénarii d’utilisation de Virtual Server 2005 concernent :

• l’automatisation des tests logiciels et des environnements de développement en optimisant les ressources matérielles,

• la consolidation des serveurs d’infrastructure réseau et d’annuaire ou des serveurs d’agences,

• et la migration d’applications anciennes.

"Gartner prévoit que les entreprises qui n’exploiteront pas les techniques de virtualisation dépenseront 25% de trop pour leurs serveurs x86." a déclaré Tom Bittman, viceprésident de la recherche chez Gartner.

Virtual Server est disponible en 2 éditions :

• Microsoft Virtual Server 2005 Enterprise Edition

• Microsoft Virtual Server 2005 Standard Edition

L’unique différence entre ces 2 éditions est l’évolutivité. En effet, la Standard Edition ne supporte que jusqu’à 4 processeurs tandis que Enterprise Edition peut supporter jusqu’à 32 processeurs.

Les 12 commandements du partage de fichiers

Le partage de fichiers peut être un point d’échange vital pour les fichiers utilisateur en collaboration, trop grands pour être envoyés comme pièces jointes de courriel. Outre la facilité d’accès pour l’utilisateur, ces partages de fichiers existent généralement sur un serveur avec des solutions de stockage redondantes. Ils réduisent le risque de perte de données consécutive à une défaillance du disque, parce que l’on peut sauvegarder les données en un point central plutôt que de sauvegarder le PC client de chaque utilisateur. (Quiconque a payé à un service de récupération de données de 1 000 à 3 000 euros pour extraire des données cruciales d’un disque dur d’un poste PC défaillant appréciera l’intérêt de la redondance du stockage sur le serveur de fichiers.)C’est pourquoi le partage de fichiers est une ressource très utilisée. Mais c’est aussi une pratique à haut risque qui peut mettre en péril les données de l’entreprise si l’on ne maîtrise pas parfaitement l’exercice. J’ai constaté que de nombreux administrateurs système ne savent pas vraiment comment les permissions de partage et de NTFS interagissent et n’ont pas un plan global solide pour leurs ressources de dossiers partagés. Pour vous aider à analyser votre environnement de dossiers partagés actuel et peut-être découvrir quelques nouvelles bonnes pratiques, j’ai recensé les 12 commandements suivants sur le partage de fichiers.

Lire l'article

Optimisation de la mémoire : mythes et réalités

Les promesses fallacieuses des optimiseurs de mémoire

En surfant sur le Web, vous avez probablement vu surgir des annonces comme « Défragmentez votre mémoire et améliorez la performance » et « Réduisez les défaillances des applications et du système et libérez la mémoire inutilisée ». Les liens vous conduisent à des utilitaires qui promettent de faire tout cela et bien plus pour 20 ou 30 euros. Est-ce trop beau pour être vrai ?Absolument ! Ces utilitaires semblent intéressants mais, au mieux, les optimiseurs de RAM sont sans effet et, au pire, ils dégradent sensiblement les performances.

On compte des dizaines de soidisant « optimiseurs de la mémoire », certains commerciaux, d’autres proposés en freeware. Peut-être même utilisez-vous l’un d’eux en ce moment sur votre système. Qu’accomplissent- ils vraiment et comment essaient-ils de vous faire croire qu’ils tiendront leurs promesses ? Jetons un coup d’oeil à l’intérieur des optimiseurs de mémoire pour voir exactement comment ils manipulent les compteurs de mémoire visibles dans Windows.

Tester les patchs

Automatiser le processus d’assurance de qualité des patches

Avant de déployer des patches, vous devez les tester pour voir s’ils n’ont pas d’effet négatif sur vos systèmes. Mais il existe tellement de patches pour tellement de produits et de versions qu’il faut automatiser les test au maximum.Voici quelques conseils pour scripter le test des patches afin d’éliminer rapidement les bogues avec le moins de travail manuel possible.

Travailler avec des API, première partie

Deux simples programmes RPG ILE montrent en quoi le fait d’appeler des API en utilisant PLIST ou des prototypes est différent

L’analyste programmeur freelance que je suis, a rencontré de nombreux programmeurs aux compétences et à l’expérience très diverses. A leur contact, j’ai constaté que beaucoup d’entre eux non seulement ne savent pas bien ce que les API peuvent faire, mais ont peur de programmer avec ...Cet article a donc pour objet de vaincre cette réticence, en montrant combien il est facile d’utiliser les API.

Nous examinerons deux versions d’un programme RPG ILE simple qui appelle une API, pour voir en quoi les deux programmes diffèrent. Le premier programme appelle une API avec une PLIST et le second appelle une API au moyen d’appels prototypés. Dans la 2e partie de cet article, nous construirons un programme utilitaire qui compare le tampon horodateur source des objets programme avec celui du fichier source, et signale les éventuelles différences.

SAN et NAS : Faits pour s’entendre

Lorsqu’ils déploient des serveurs Windows, les administrateurs attachent généralement les disques directement à chaque serveur...Par exemple, l’environnement de la société B a plusieurs serveurs pour l’édition, la production, les ventes, les ressources humaines et les finances. Et chacun de ces serveurs a son propre stockage.

Mais avec cette méthode il est difficile de prévoir exactement la quantité de stockage nécessaire à chaque groupe d’utilisateurs. Par conséquent, les administrateurs commencent souvent par attacher 100 Go de stockage, par exemple, à chaque serveur. Mais, après un certain temps, il arrive qu’un département utilise 90 % de son stockage tandis qu’un autre n’en utilise que 20 %. Comme il est difficile de réallouer du stockage d’un département à un autre dans un environnement DAS (Direct Attached Storage), la plupart des services IT se contentent d’ajouter du stockage disque au fur et à mesure des besoins, aux serveurs en manque. Une vaste enquête révèle que 70 % environ du DAS sont généralement gaspillés parce qu’il est mal alloué et trop difficile à réallouer.

Aux problèmes de réallocation du DAS, s’en ajoute un autre : le logiciel de gestion des quotas qui accompagne Windows 2000 Server permet de contrôler la quantité de stockage par utilisateur mais pas le type de fichiers qu’un utilisateur peut stocker. Un groupe de participants à un récent Webcast de stockage a constaté que, le plus souvent, plus de 30 % des fichiers sauvegardés dans des environnements DAS étaient sans intérêt pour la gestion, du genre MP3. Autrement dit, presque un tiers de l’espace disque que l’IT d’entreprise achète et maintient est utilisé pour des fichiers étrangers à la gestion.

Les SAN (Storage Area Networks) et le NAS (Networked Attached Storage) permettent d’ajouter et de réallouer facilement du stockage et d’empêcher le stockage de types de fichiers non professionnels. Les SAN sont optimisés pour les transferts de données de type bloc à forts volumes qui caractérisent les bases de données et les serveurs d’applications. Le NAS est optimisé pour le service de fichiers. C’est pourquoi les SAN et le NAS sont souvent considérés comme des technologies mutuellement exclusives. Il n’en est rien et, en réalité, les SAN et le NAS se complètent à merveille et peuvent être combinés pour répondre à des besoins de stockage IT courants.

Déploiement de Windows XP à base d’images

Personnalisez Sysprep et optimisez vos images système

Si vous envisagez de déployer Windows XP à base d’images dans votre entreprise, il est probable que vous avez lu la documentation de l’outil Sysprep de Microsoft (sysprep.exe) et que vous avez pesé les avantages et les inconvénients qu’il y a à maintenir des images système...Compte tenu des besoins informatiques de votre société et des explications suivantes sur la meilleure utilisation des fonctions de préparation système de Sysprep, vous serez en mesure de maintenir un plus petit nombre d’images, et des images qui seront utiles plus longtemps. Le temps et l’effort que vous consacrerez à affiner le processus d’imagerie sera bénéfique, même s’il retarde un peu le début du déploiement.

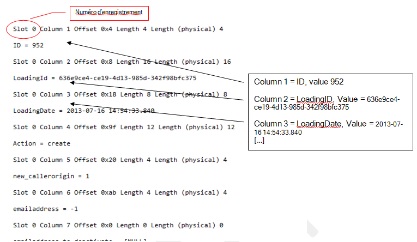

Pilote automatique

par Herts Chen - Mis en ligne le 18/02/2004

Raccourcissez le temps de réplication instantanée et de configuration avec

cet outil d'automatisation

Quand vous appliquez la réplication

instantanée à de grandes bases de données,

l'étape qui supprime les enregistrements

cibles et celle qui copie en

bloc les données sources dans des

tables cibles indexées peuvent créer

deux goulets d'étranglement des performances...Quand vous appliquez la réplication

instantanée à de grandes bases de données,

l'étape qui supprime les enregistrements

cibles et celle qui copie en

bloc les données sources dans des

tables cibles indexées peuvent créer

deux goulets d'étranglement des performances.

Pour éliminer ces goulets d'étranglement - et donc optimiser la

réplication - vous pouvez ajouter des

étapes personnalisées aux jobs

Snapshot and Distribution Agent. Dans

le premier article de cette série en trois

parties, « Ouvrez la voie à la réplication

snapshot à grande échelle », octobre

2002, (ou sur www.itpro.fr), j'analysais la performance d'une réplication

instantanée et introduisais les

étapes personnalisées. Le deuxième article,

« Personnalisez votre réplication

instantanée à la main », janvier 2003,

(ou sur www.itpro.fr), détaillait l'implémentation

manuelle complète de ces

étapes. Dans cet article de conclusion,

voyons comment réaliser une personnalisation

rapide, fiable et reproductible

en utilisant SQL-DMO (SQL

Distributed Management Objects)

pour automatiser le processus de personnalisation.

La performance interactive d’IBM trop chère

Je suis un modeste développeur dans un site iSeries moyen. Depuis 15 ans, j’ai écrit des applications en RPG, VARPG, CL, SQL, Visual Basic et Net.Data. Comme beaucoup de partisans de l’iSeries, je pense qu’IBM a pris quelques mauvaises décisions techniques et marketing à propos de la machine que j’aime – pourtant je continue à pencher pour IBM. Peut-être par faiblesse de caractère ?Le changement le plus contrariant qu’IBM a apporté à l’iSeries est la tarification de la performance interactive. Quand je rencontre certains de mes pairs, je suis étonné de voir que bien peu d’entre eux remarquent la manière dont IBM a structuré son tarif interactif sur les nouvelles machines iSeries. Quand on examine le CPW total et les mesures interactives pour un iSeries, les mesures indiquent le pourcentage de la CPU utilisable pour le traitement interactif. Ainsi, une machine avec un CPW total de 560 et une mesure interactive de 70 signifie que l’on ne peut utiliser que 12,5 % de la CPU pour le traitement interactif.

Lire l'article

Le clustering réparti géographiquement

Le clustering améliore la disponibilité, la fiabilité et l’évolutivité des serveurs sous Windows. Une configuration clustering classique favorisant la disponibilité, est constituée de plusieurs nœuds semblables, reliés en principe à un sous-système de stockage partagé. Quand ces nœuds fonctionnent dans une configuration active-active, la charge de travail est répartie entre les nœuds en cluster ...

Mais le principal objectif d’un cluster est d’assurer le failover en cas de défaillance d’une application ou d’un élément matériel : on est là dans une configuration active-passive.

La configuration clustering active-passive a une variante : la réplication de données au lieu du stockage partagé. La réplication de données permet de pratiquer le clustering sur une liaison en réseau étendu. Les produits qui permettent ce type de cluster offrent de nombreux avantages au-delà de ce que les données dispersées géographiquement offrent sur le plan antisinistre. Ainsi, la possibilité de spécifier des configurations matérielles différentes pour chaque nœud diminue le coût du matériel. En outre, l’existence d’une source de données répliquées peut s’avérer très utile pour la sauvegarde des données, le test des applications, et la migration et le test des OS.

J’ai rassemblé trois produits permettant le clustering basé sur la réplication avec failover – BrightStor High-Availability Manager (nommé précédemment SurviveIT2000) de Computer Associates (CA), Double-Take for Windows 2000/NT 4.1 de NSI Software, et Legato Octopus for Windows NT and 2000 4.2 de Legato Systems. (Depuis, Legato a changé le nom du produit Octopus en Legato RepliStor et a présenté la version 5.0.) J’ai testé ces produits pour juger leur capacité de reprise et leur haute disponibilité face à divers incidents. J’ai également examiné certaines possibilités uniques qui rendent chaque produit mieux adapté à une situation donnée. VERITAS Cluster Server 2.0 for Windows 2000 de VERITAS Software et LifeKeeper for Windows 2000 4.0 de SteelEye Technology offrent des possibilités similaires mais n’étaient pas disponibles pour le test.

Lire l'article

Optimiser les performances disque ATA, 2ème partie

Dans l’article « Optimiser les performances disque ATA, 1re partie », avril 2002, j’expliquais comment tirer les meilleures performances des disques ATA (aussi appelés IDE) dans Windows 2000. Je décrivais les derniers standards ATA et évoquais quelques pièges matériels auxquels vous pourriez être confrontés en essayant de configurer vos disques ATA (ATA/33, ATA/66, ATA/100, par exemple). Ce mois-ci, je conclus ma série en deux parties en parlant du logiciel.J’essaie également de combler certaines lacunes de la documentation Knowledge Base incomplète de Microsoft à propos d’ATA. Mais avant de suivre les étapes ou d’appliquer les conseils de cet article, assurez-vous que vous avez suivi les indications sur le matériel expliquées le mois dernier.

Lire l'article

Peindre le petit cochon

Il y a quelques années, alors que j’étudiais un livre de phrases et expressions en espagnol pour préparer un voyage au Honduras, j’ai rencontré la phrase : « Votre porcelet est le plus mignon de tous dans le bus ». Ca c’est une entrée en matière ! Cette phrase m’a conduit à réfléchir sur nos applications iSeries héritées et sur le bien-fondé de les étendre à de nouveaux clients ...Pouvons-nous vraiment rendre nos applications iSeries héritées les plus mignonnes dans le bus, simplement en leur donnant un nouveau visage ?

Lire l'article

10 trucs pour récupérer votre espace disques

La plupart des nouveaux systèmes Windows NT sont dotés de quantités prodigieuses d’espace disque local ; mais tout le monde n’a pas la chance d’utiliser un de ces monstres. Beaucoup d’entre nous gèrent des systèmes sur lesquels l’espace disque est un bien précieux. Ce mois-ci je vous fais part de quelques astuces pour récupérer l’espace disque dur.

Lire l'article

Optimiser les sous-systèmes disques

Des performances ! Tout le monde veut que les serveurs et les stations de travail NT tournent le plus vite possible. Or l’optimisation d’un sous-système disque est importante pour améliorer les performances globales d’une solution NT.Cet article décrit comment obtenir des performances maximales des ressources supplémentaires ajoutées lors de la mise en œuvre de sous-systèmes disques et de grappes RAID supplémentaires, sans tenir compte des mises au point matérielles spécifiques à tel ou tel constructeur. Pour optimiser rapidement le sous-système disque (RAID matériel ou logiciel), on peut faire appel à des outils intégrés de Windows NT ou à un freeware. Pour réaliser cette tâche, il importe de comprendre les caractéristiques individuelles de performances des disques ou de la technologie RAID, selon le choix que vous avez fait, et les charges de travail de votre sous-système disque existant. Ces informations vous permettront d’équilibrer les charges de votre sous-système disque et d’optimiser la taille des unités d’allocation des disques. Enfin, comme l’accroissement des performances peut varier en fonction de l’environnement informatique, j’expliquerai comment j’ai optimisé et testé mon sous-système disques.

Lire l'article

Au coeur de la gestion du stockage – Première partie

L'évolution de la gestion du stockage de Windows NT débute avec DOS ; le premier OS de Microsoft. Avec l'augmentation de la taille des disques durs, DOS a du s'adapter. Pour cela, une des premières décisions prises par Microsoft a été de permettre à DOS de créer de multiples partitions, ou disques logiques, sur un même disque physique.Avec l'introduction des disques logiques, DOS a pu formater chaque partition avec un type de système de fichiers différent (FAT12 ou FAT 16) et affecter à chaque partition une lettre d'unité différente. DOS 3 et 4 étaient sévèrement limités quant à la taille et au nombre de partitions que l'on pouvait créer, mais avec DOS 5, le système de partitions est arrivé à sa pleine maturité : on pouvait diviser un disque en autant de partition de quelque taille que ce fût. Windows NT a emprunté le système des partitions du DOS afin d'assurer la compatibilité des disques avec DOS et Windows 3.x, et pour que l'équipe de développement de NT puisse s'appuyer sur des composants éprouvés pour la gestion des disques.

Dans Windows NT, Microsoft a fait évoluer les concepts de base du système de partitionnement de base du DOS pour supporter les fonctions de gestion des disques des OS d'entreprise : le spanning de disques et la tolérance aux pannes. Dès la première version de Windows NT, les administrateurs système ont pu créer des volumes comprenant plusieurs partitions.

Cette possibilité permet de créer de grands volumes consistant en partitions réparties sur plusieurs disques physiques et permet la mise en œuvre de la tolérance de panne grâce à la redondance logicielle des données. Le support du partitionnement de Windows NT est assez souple pour supporter la plupart des besoins de gestion du stockage, mais ce support comporte plusieurs inconvénients. Un de ces inconvénients est que la plupart des modifications de configuration des disques nécessitent un redémarrage pour entrer en vigueur. Dans l'environnement actuel des serveurs, qui doivent rester on-line pendant des mois, voire des années, tout redémarrage (même planifié) est un problème majeur.

Autre inconvénient, le Registre de Windows NT stocke les informations avancées de configuration des disques. Ce choix a pour conséquence de compliquer le déplacement des informations de configuration lorsque l'on déplace des disques d'un serveur à un autre. Il est facile de perdre des informations de configuration lorsque vous devez réinstaller le disque. Enfin, le fait que NT exige que chaque volume ait une unique lettre d'unité dans la tranche A à Z, fixe un plafond au nombre de volumes locaux et distants qu'un utilisateur puisse créer.

Windows 2000 élimine bon nombre de limitations des tâches de gestion du stockage de NT 4.0Windows 2000 élimine bon nombre de limitations des tâches de gestion du stockage de NT 4.0 avec une nuée de nouvelles améliorations en la matière. Depuis les points de montage de volumes, qui permettent de supprimer la limite du nombre de volumes possibles, au support intégré de la migration des fichiers, en passant par le stockage hors connexion ou la gestion du stockage sans redémarrage, Windows 2000 place sa gestion du stockage à un niveau équivalent à celui des UNIX les plus évolués. Détaillons les internes de la gestion du stockage dans Windows NT et 2000.

NAS ou SAN, que choisir ?

La consolidation du stockage d'entreprise a le vent en poupe, parce qu'elle accroît l'efficacité, diminue la redondance et simplifie la gestion. Qui n'a pas entendu parler de l'importance du stockage pour les entreprises et de ces deux technologies de stockage dont on parle tant en ce moment : le NAS (Network Attached Storage) et le SAN (Storage Area Network).Les périphériques NAS sont des dispositifs de stockage - de gros serveurs spécialisés que l'on connecte au réseau - qui n'exécutent qu'une tâche et fonctionnent très bien : ils livrent très rapidement les fichiers. La capacité des grands dispositifs NAS est de l'ordre du téraoctet. Les SAN sont, quant à eux, des réseaux multiserveur, multistockage pouvant dépasser les 400 To. Un SAN sert de réseau secondaire à un LAN. Chaque serveur devant accéder au SAN est relié au LAN par une connexion fibre channel. Ce réseau secondaire soulage le réseau principal des charges massives de transfert des données, puisque le trafic de sauvegarde a lieu entre périphériques de stockage à l'intérieur du SAN. Les dispositifs NAS et les SAN ont des fonctions nettement différentes. Le premier peut effectuer certaines fonctions qu'un SAN ne peut pas effectuer et un SAN offre l'évolutivité. Examinons les technologies du NAS et du SAN et les scénarios dans lesquels l'une est préférable à l'autre.

Lire l'articleLes plus consultés sur iTPro.fr

- Quel impact d’une cyberguerre sur les organisations ?

- Menaces cyber sur le secteur énergétique européen !

- Les stratégies IA pour la survie de l’entreprise !

- Protégez l’accès non authentifié de vos réunions

- Télécommunications et durabilité : les défis d’une transition verte dans un secteur en mutation