En 1893, la compagnie Westinghouse entreprenait de déployer le premier réseau électrique des États-Unis, en exploitant le système du courant alternatif préconisé par le scientifique Nikola Tesla.

Datacenter : comment repenser la distribution électrique ?

Aussi étonnant que cela puisse paraître, la façon de distribuer l’électricité n’a pas beaucoup évolué depuis cette époque. L’histoire des datacentres, bien plus récente, subit la même inertie. Les hébergeurs redondent évidemment certains éléments (UPS, transformateurs) de la chaîne de distribution du courant, pour augmenter la disponibilité de leurs infrastructures. Mais ils en ont conservé le principe général. De quelle manière peut-on aujourd’hui optimiser la distribution électrique au sein des datacentres, qui représenteraient aujourd’hui entre 1,5 et 2 % de la consommation électrique mondiale ? Quelles sont les difficultés ? De quelle manière ces changements pourraient réduire le risque de panne ? États des lieux par Germain Masse, directeur d’OVH Canada.

Intérêt économique VS réduction des « domaines de panne »

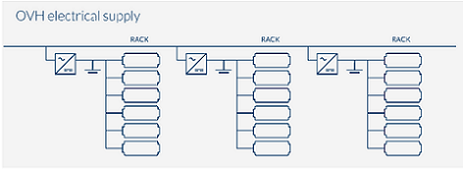

Lorsque l’on conçoit un datacentre, deux logiques s’affrontent. D’un côté, il y a la volonté de segmenter le plus possible la distribution électrique, en multipliant le nombre de « petits » transformateurs et d’UPS (aussi appelés « onduleurs »), ceci pour diminuer l’impact causé par la défaillance d’un équipement. De l’autre côté, cette stratégie augmente les coûts d’installation et de maintenance, et en définitive alourdit la facture du client final. Aujourd’hui, le point d’équilibre est généralement atteint avec le déploiement de transformateurs de 1 à 2 Mégawatts, en aval desquels sont installés des UPS d’une capacité de 400 kilowatts à 1 Mégawatt (à noter que les générations actuelles d’onduleurs sont souvent un assemblage de modules de 200 à 400 kW). Ces UPS, de par leur puissance électrique importante et leur criticité, nous obligent à accepter des domaines de panne (domain of failure) relativement importants, de l’ordre de 3 000 à 6 000 machines. (Les UPS sont sollicités dès qu’une coupure électrique survient, le temps de basculer sur une arrivée électrique de secours et/ou de démarrer les groupes électrogènes, ce qui prend entre 15 secondes et 1 minute).

Ce dilemme, enjeu majeur dans les datacentres, est appelé chez OVH le « domaine de panne ». En cas de défaut d’un équipement, l’ensemble des serveurs impactés se situent dans le même domaine de panne. Selon l’architecture bâtie, certains utilisateurs vont préférer regrouper des serveurs dans le même domaine de panne (dans le cas par exemple, où plusieurs serveurs doivent impérativement communiquer entre eux), ou au contraire éclater les machines entre différents domaines de panne (nécessaire pour un plan de reprise d’activité, par exemple). Pour répondre à ce type de besoins, OVH propose de localiser ses serveurs dans les datacentres (Roubaix, Gravelines ou Strasbourg en Europe ; Beauharnois au Canada) et le choix de la baie. Un casse-tête logistique, mais un vrai plus pour les utilisateurs.

Et si l’alternative était le courant continu ?

Partout dans le monde, le courant électrique est distribué en AC (courant alternatif, ou alternating current en anglais). A contrario, les éléments qui constituent un serveur informatique (processeur, disques…) sont alimentés en DC (courant continu ou direct current en anglais) de 3,3 ; 5 ou 12 volts suivant les composants.

Le courant électrique arrive donc en AC à l’entrée du datacentre et subit de nombreuses transformations jusqu’à alimenter en courant continu les éléments d’un serveur. Quand on y regarde de près, voilà ce qu’il se passe dans un datacentre aux Etats-Unis :

(((IMG7743)))

Un minimum de logique voudrait qu’on supprime la phase de DC/AC et AC/DC entre l’UPS et le serveur. Mais le milieu de l’électricité n’évolue malheureusement pas aussi vite que celui de l’informatique…

Allons encore plus loin : pourquoi n’approvisionnerait-on pas directement les datacentres en courant continu ? Sur la base des travaux de Thomas Edison, l’électricité était à l’origine distribuée en courant continu. Simplement, pour diminuer les pertes lors du transport du courant (continu comme alternatif), il est nécessaire de baisser son intensité en élevant sa tension, en vertu du fameux effet Joule. Or, la modification de la tension d’un courant continu provoquait beaucoup de pertes énergétiques. C’est pourquoi les compagnies d’électricité donnèrent finalement raison à Nikola Tesla et son système de courant alternatif.

Aujourd’hui la donne a changé : on peut, à l’aide de composants d’électronique de puissance (plus connus sous le nom de convertisseurs) modifier la tension électrique d’un courant continu pour le transporter en limitant les pertes énergétiques. Le courant continu est d’ailleurs déjà privilégié sur les très longues distances ou dans le cas de câbles souterrains ou sous-marins, entre autres parce que seuls deux câbles sont nécessaires à son transport (contre trois pour le courant alternatif).

L’intérêt d’approvisionner les datacentres en courant continu, outre le fait de simplifier la chaîne de distribution électrique (réduire le nombre d’équipements = réduire le risque de panne), est la possibilité de coupler différentes sources d’énergie entre elles pour, selon les cas, augmenter la tension, l’intensité et la redondance. L’essor récent de nouveaux modes de production d’électricité, tels que le photovoltaïque ou les piles à combustible, favorisera probablement cette évolution. Mais celle-ci se heurte actuellement à deux freins. Le premier est économique : les équipements pour le courant continu ont un coût actuellement supérieur. Le second est psychologique : il s’agit tout simplement de la méconnaissance des opérateurs…

UPS dans la baie ou dans le serveur : quelle est la meilleure stratégie ?

Quelle que soit la stratégie choisie pour évoluer vers le DC – transformation AC/DC à l’entrée du datacentre, au niveau de l’UPS, au niveau de la salle ou de la baie, ou du serveur – il faut remplacer l’alimentation du serveur.

Microsoft a récemment divulgué, dans le cadre de sa contribution à l’Open Compute Project, les plans d’une alimentation de serveur incluant des batteries Li-ion (Fig 2). Une innovation que la firme a nommé Local Energy Storage (LES). Ce concept, en réalité, n’est pas nouveau, puisqu’en 2012 Supermicro annonçait la commercialisation d’alimentations de serveur avec batteries (Fig 3), 3 ans après que Google eut dévoilé utiliser ce procédé dans certaines de ses machines (Fig 4).

Chez OVH, l’alimentation dans le serveur est remplacée par un simple étage de conversion DC/DC et, dans chaque baie électrique, un équipement (nom de code Altigo) prend en entrée un courant AC pour produire un courant continu (24 volts ou 48 volts suivant les cas).

Cette solution permet d’utiliser les mêmes batteries que celles des UPS standards, qui sont produites en masse. C’est aujourd’hui, bien plus économique que d’installer une batterie au sein de chaque serveur. Mais cette situation évoluera peut-être, en fonction du succès que rencontrera ce nouveau type d’alimentation avec batterie intégrée.

(((IMG7744)))

(((IMG7745)))

(((IMG7746)))

Téléchargez cette ressource

Prédictions 2025 des menaces persistantes avancées

L'analyse et l'évolution du paysage des menaces persistantes avancées (APT) et des conséquences sur vos infrastructures IT. Découvrez la synthèse des prédictions, tendances et recommandations pour 2025 avec les experts Kaspersky.

Les articles les plus consultés

- Databricks lève 1 milliard de dollars !

- Les projets d’intégration augmentent la charge de travail des services IT

- 9 défis de transformation digitale !

- Stockage autonome, Evolutivité & Gestion intelligente, Pure Storage offre de nouvelles perspectives aux entreprises

- Intelligence Artificielle : DeepKube sécurise en profondeur les données des entreprises

Les plus consultés sur iTPro.fr

- Java fête ses 30 ans et se tourne vers l’avenir !

- IA : l’urgence de combler le fossé entre ambition et exécution

- Data center : l’efficacité énergétique au cœur de la révolution

- La recherche clinique boostée par l’IA et le cloud de confiance

- Plus d’identités machines que d’identités humaines en entreprise !