Avec la virtualisation et l’augmentation de la densité des Datacenter, Windows 2008 R2 avait déjà permis de réduire significativement les coûts de possession.

Une plateforme continuellement disponible avec Windows Server 2012

Windows 2012 va encore plus loin et s’annonce comme un OS de transition destiné à permettre un nouveau changement d’échelle.

Windows Server 2012 a été pensé pour faciliter la gestion des petites infrastructures de quelques serveurs (Direct Access Essential, Hyper-V sur partages SMB, Storage space etc.), mais aussi pour servir de fondation pour les infrastructures composées de milliers de machines (Scale out file server, SMB Multichannel …).

Parler de toutes les fonctionnalités inédites de cette dernière version dépasse largement l’espace qui m’est accordé dans ce numéro. En tant qu’architecte spécialiste des infrastructures Microsoft, j’ai choisi d’apporter un focus particulier sur certaines nouveautés concernant la gestion et l’utilisation du stockage. Parmi les nouveautés, on remarquera notamment l’apparition du concept de plateforme « continuellement disponible ». Là où le concept de haute disponibilité permet une restauration rapide et automatique du service en cas de panne matérielle (Failover Cluster), les infrastructures continuellement disponibles assurent un service ininterrompu, même en cas de panne ou de maintenance (bascule sans interruption de service).

A partir des améliorations disponibles dans Windows Server 2012, Microsoft développe en partenariat avec les constructeurs des solutions permettant de disposer d’un stockage évolutif et économique, sans sacrifier aux performances.

Storage Space

Les « Storage Spaces » sont une évolution des fonctionnalités offertes par les disques dynamiques. Ces derniers introduisent la virtualisation du stockage au sein de Windows Server 2012 en intercalant une couche d’abstraction entre les disques physiques vus par le système et le stockage consommé par les applications.

En regroupant les disques physiques au sein de « pool » de stockage, il est désormais possible de créer des volumes comparables aux disques VHDX utilisés pour les machines virtuelles. Voir figure ci-dessous.

(((IMG6735)))

Figure 1

Ces volumes « virtuels » sont vus par le système comme des disques physiques et peuvent être «Thin provisionnés », c’est-à-dire ne consommer réellement que l’espace occupé par les données. Avec ce système, il est possible de présenter aux applications plus d’espace qu’il n’est disponible physiquement. Cette flexibilité permet de gérer plus efficacement les coûts relatifs au stockage, tout en satisfaisant les demandes des utilisateurs. Voir figure ci-dessous.

(((IMG6736)))

Figure 2

Grâce à l’abstraction créée entre le stockage consommé et les disques physiques, l’ajout de capacité au sein d’un pool se fait de manière totalement transparente pour les utilisateurs et ne nécessite aucune interruption.

Pensés entre autres pour servir d’alternative à un NAS, les « Storage Spaces » offrent des fonctionnalités optionnelles de redondance des données (Miroir ou Parité) pour apporter une résilience sur la base de groupes de disques en vrac JBOD (Just a Bunch Of Disk). Attention cependant à ne pas utiliser ces fonctions de parité sur des volumes déjà en RAID matériel.

Totalement intégrés avec les fonctionnalités de « Failover Clustering », les « Storage Spaces » sont le complément idéal des « Scale Out File Server », un des nouveaux rôles de Windows Server 2012.

Scale Out File Server (Partage de fichiers Actifs/ Actifs)

Introduit avec Windows Server 2012, ce nouveau serveur de fichier en cluster permet entre autres d’héberger des disques de machines virtuelles Hyper-V par le biais d’un partage SMB V3. Dans ce nouveau rôle, tous les partages sont montés et accédés depuis tous les noeuds simultanément (cluster Actif / Actif). Ceci permet une meilleure répartition des charges avec une augmentation de la bande passante disponible jusqu’à 8 noeuds.

L’utilisation de SMB V3 fournit une bascule transparente sur un noeud alternatif en cas de maintenance planifiée ou de panne matérielle, sans interruption de service.

Les partages SMB V3 supportent également la technologie VSS (Volume Shadow Copy) et sont compatibles avec l’utilisation des disques virtuels Hyper-V (Snapshots). Voir figure ci-dessous.

(((IMG6737)))

Figure 3 : Scale out File Server

Note : En bénéficiant d’une continuité de service même en cas de panne matérielle, il n’est plus impératif de disposer d’une redondance forte au niveau de chaque noeud du cluster (cartes HBA, cartes réseau, alimentations etc.). Les économies réalisées peuvent alors être réinvesties dans un noeud supplémentaire.

SMB Multi Channel

Disponible avec SMB V3, le support du multi Channel apporte une amélioration drastique des performances. Sans Multi Channel, une liaison entre un client et un serveur SMB est établie par le biais d’une session TCP/IP unique, associée avec un seul des coeurs disponibles de la machine. Si de très nombreuses petites transactions sont effectuées, l’unique coeur associé peut devenir un véritable goulet d’étranglement. Voir figure ci-dessous.

(((IMG6738)))

Figure 4 : Partage SMB V3 sans multi channel

La plupart des cartes actuelles offre des fonctions RSS (Receive Side Scaling) qui permettent de répartir les sessions TCP/IP sur de multiples processeurs. SMB Multi Channel tire parti de cette fonctionnalité pour créer de multiples sessions et ainsi les répartir sur un plus grand nombre de coeurs, évitant les goulets d’étranglement et améliorant la montée en charge quand de nombreux I/O sont demandés. Voir figure ci-dessous.

(((IMG6739)))

Figure 5 : Partage SMB V3 avec multi channel

Mais ce n’est pas tout, en complément des fonctions RSS, le multi channel est aussi capable de tirer parti des cartes réseau additionnelles pour augmenter la bande passante (ex : 4 cartes 1Gbps offrent alors une bande passante de 4Gbps) et de s’en servir pour fournir une tolérance de panne (à ne pas confondre avec le Nic Teaming qui est encore une autre fonctionnalité).

Le multi Channel est aussi responsable de la détection des fonctions RDMA (Remote Direct Access Memory). Plus chères et moins répandues, les cartes compatibles RDMA (10Gbits) permettent de réduire drastiquement la charge CPU et la latence.

Associées à l’utilisation d’un serveur de fichier pour fournir du stockage à des applications exigeantes en I/O (Ex : des disques de machines virtuelles Hyper-V ou des bases SQL), ces cartes permettent d’approcher les performances obtenues sur des réseaux de type Fibre Channel.

Internal Clustered PCI RAID Support

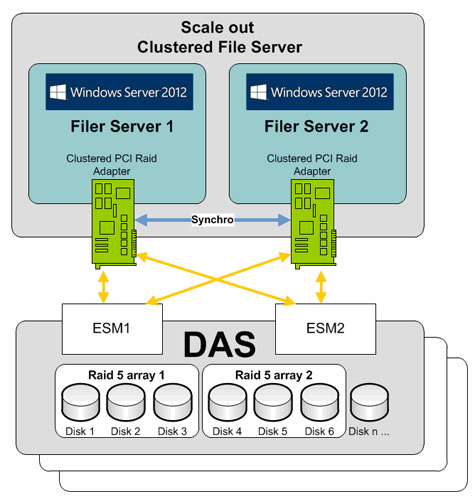

En complément, du « Scale out File Server », Windows Server 2012 supporte l’utilisation de cartes RAID « en cluster », pour obtenir un niveau de performance et de disponibilité similaire à un SAN. Dans une configuration de ce type, le cache des cartes RAID est gardé synchronisé en permanence par une liaison SAS. Grâce à cette liaison, la cohérence des données inscrites sur les disques est assurée même en cas de panne matérielle d’un des noeuds.

Associé aux autres fonctionnalités de Windows Server 2012 (Storage Space, Scale Out File Server, SMB MultiChannel), le clustering de carte RAID fournit une alternative économique au SAN sans sacrifier aux performances. Voir figure ci-dessous.

(((IMG6740)))

Figure 6 : Internal Clustered PCI Raid Adapter

Téléchargez cette ressource

Sécurité et gouvernance des applications d’IA

Les applications d’IA se multipliant dans les entreprises, ces dernières se doivent d’établir un cadre de gouvernance qui tient compte des risques de sécurité et des défis associés. Ce livre blanc vous offre les connaissances et les outils nécessaires à une gouvernance garante de la sécurité de vos applications d’IA.

Les articles les plus consultés

- Partager vos images, vidéos, musique et imprimante avec le Groupe résidentiel

- Cybersécurité Active Directory et les attaques de nouvelle génération

- IBM i célèbre ses 25 ans

- Activer la mise en veille prolongée dans Windows 10

- N° 2 : Il faut supporter des langues multiples dans SharePoint Portal Server

Les plus consultés sur iTPro.fr

- Java fête ses 30 ans et se tourne vers l’avenir !

- IA : l’urgence de combler le fossé entre ambition et exécution

- Data center : l’efficacité énergétique au cœur de la révolution

- La recherche clinique boostée par l’IA et le cloud de confiance

- Plus d’identités machines que d’identités humaines en entreprise !