Conférences Internet et Sécurité

Prise en compte des aspects légaux : un enjeu majeur pour les entreprises !

Participez à cette conférence et découvrez comment mieux appréhender les aspects légaux et la sécurisation des accès Internet.

SQL Server Actualités – Semaine 20 – 2006

Les actualités SQL Server de la semaine du 15 au 21 Mai 2006

Lire l'article

Type de données T-SQL Dafetime

Le type de données datetime génère beaucoup de questions et de confusion au sein de

A la différence d’autres grandes plates-formes de base de données, SQL Server ne fournit pas de types de données de date et d’heure discrètes. En, fait, datetime assume à lui seul a tâche de ces deux types de données. Cette rubrique apporte des réponses à six questions posées fréquemment sur l’utilisation du type de données datetime de SQL Server.

Lire l'article

SQL Server, nouvelles éditions : Express, Workgroup, Standard et Enterprise

Microsoft a remodelé la famille de produits SQL Server 2005 afin de mieux répondre aux besoins de tous ses clients, quelle que ce soit leur activité, et ce à l’aide de quatre nouvelles éditions : Express (version gratuite), Workgroup, Standard et Enterprise.

Découvrez des informations détaillées sur les différentes éditions.

Lire l'article

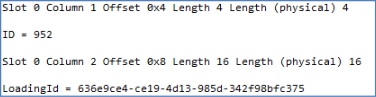

Option d’insertion en bloc pour ADO.NET

Les clients me demandent souvent comment insérer en bloc des données dans SQL Server à partir d’applications ADO.NET. Il n’est pas facile de répondre à cette question car ADO.NET ne comporte aucun objet intégré d’insertion en

bloc. La méthode la plus simple pour effectuer ce type d’insertion consiste à charger le DataSet avec plusieurs groupes de lignes volumineux, puis à envoyer les mises à jour à SQL Server. Vous pouvez aussi employer l’objet SqlCommand au sein d’une procédure stockée ou d’une instruction INSERT paramétrée afin d’insérer les données. Toutefois, chacune de ces deux approches est lente car elles effectuent une insertion pour chaque ligne insérée. Heureusement, les méthodes substitution suivantes sont plus performantes. Gardez à l’esprit que pour obtenir une rapidité d’insertion maximale, il est nécessaire de supprimer les index concernés or de les importer dans des tables temporaires.

Kit ressources techniques ASP.NET

par Michael Otey - Mis en ligne le 03/05/2006 - Publié en Février 2005

Visual Studio .NET et .NET Framework proposent ASP.NET, un langage qui a inauguré une nouvelle ère en matière de programmation Web. ASP.NET propose un environnement de développement plus productif et une plateforme Web nettement plus performante que Visual Studio 6.0, basée sur COM, et le langage ASP (Active Server Pages).Le nouveau Kit de ressources techniques ASP.NET de Microsoft vient encore améliorer l’approche de la programmation ASP.NET en proposant un ensemble de didacticiels, d’exemples de code utiles, de chapitres extraits d’ouvrages et d’utilitaires gratuits. Ce kit est téléchargeable gratuitement à l’adresse http://msdn.microsoft.com/ asp.net/asprk/ . Cette rubrique présente quatre des fonctionnalités les plus utiles de ce kit.

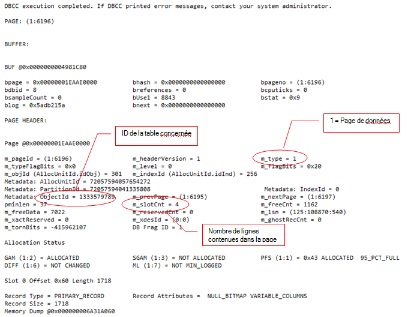

Réindexation Automatique

L’utilitaire DBCC SHOWCONTIG élimine le stress de la défragmentation des index

La maintenance courante, notamment les tâches de réindexation, est importante

afin de préserver les performances optimales d’exécution de vos bases de

données. Lorsque vous utilisez des instructions INSERT, UPDATE ou DELETE pour

modifier les données des tables, il peut y avoir fragmentation des index. Ce phénomène

est susceptible de se produire si la séquence logique des pages est interrompue

ou si une page d’index contient moins que le volume maximum de données,

créant ainsi un vide dans la page de données ou l’index. A mesure que les

index deviennent fragmentés, les lectures de données deviennent inefficaces lors

de l’accès aux tables et les performances de la base de données diminuent.

Lire l'article

Les nouveautés de Whidbey

par Michael Otey - Mis en ligne le 03/05/2006 - Publié en Février 2005

Les développeurs Visual Basic (VB) 6.0 apprécieront la prochaine mouture de Visual Studio .NET, nom de code Whidbey, prévue pour l’année prochaine. Bien que Visual Studio .NET constitue un environnement de développement remarquable par rapport aux outils de développement proposés auparavant par Microsoft, il n’est pas exempt de lacunes dans certains domaines. Par exemple, plusieurs fonctionnalités qui faisaient de VB 6.0 un environnement de développement productif, notamment la fonction Edit and Continue (Modifier et continuer), n’ont pas été reprises dans Visual Studio .NET. Néanmoins, Microsoft entend bien proposer de nombreuses améliorations dans sa nouvelle version, y compris cette fonction Edit and Continue. Voici sept des nouveautés très attendues de Whidbey.

SQL Server Actualités – Semaine 38 – 2006

Les actualités SQL Server de la semaine du 18 au 24 Septembre 2006

Lire l'article

Des séminaires pour découvrir SQL Server 2005

TechNet se déplace dans plusieurs villes de France à partir du mois de février et vous propose deux séminaires techniques gratuits pour découvrir SQL Server 2005 ou parfaire votre expertise sur le produit.

Plus d’informations sur http://www.microsoft.com/france/sql/sql2005/seminaires.mspx

Lire l'article

FaxCore Integration Server

FaxCore annonce FaxCore Integration Server (FIS), solution d’intégration de fax basée sur les technologies .Net.

FIS comprend une licence de serveur unique, un kit Sofware Development Kit (SDK) .Net, une base de données compatible SQL et une intégration mail SMTP. Le produit supporte jusqu’à 25 utilisateurs.

Lire l'article

SQL Server Actualités – Semaine 16 – 2006

Les actualités SQL Server de la semaine du 17 au 23 Avril 2006

Lire l'article

SQL Server, par Jérôme Gabillaud

Cet ouvrage de Jérôme Gabillaud ( Editions ENI) détaille les principes de mise en oeuvre d'une base SQL Server 2005, les syntaxes SQL et Transact.SQL pour la gestion des données et pour leur manipulation.

Il comporte également la description des outils graphiques de gestion des données.

Lire l'article

Les services Web en toute simplicité

par Rick Dobson - Mis en ligne le 19/04/2006 - Publié en Février 2005

Lors du lancement officiel de Microsoft .NET Framework, Bill Gates a effectué la promotion des services Web en présentant « SQL Server 2000 Web Services Toolkit », un kit de programmation qui prend en charge XML pour la troisième version Web de SQL Server 2000 (SQL XML 3.0). Web Services Toolkit est un véritable joyau qui vous permet de créer graphiquement un service Web exposant des objets de base de données tels que des procédures stockées et des fonctions définies par l’utilisateur (UDF). Si vous savez manipuler le langage T-SQL et les procédures stockées, SQLXML 3.0 fera de vous un magicien des services Web sans formation lourde.Microsoft a sorti deux Service Packs pour SQLXML 3.0. La dernière mise à jour, à savoir le Service Pack 2 (SP2), est téléchargeable gratuitement à l’adresse http://www.microsoft. com/downloads/details.aspx?familyid= 4c8033a9-cf10-4e22-8004-47 7098a407ac&displaylang=en. Le présent article va au-delà des notions fondamentales de la création d’un service Web. Je vais en effet m’appuyer sur un exemple de service Web d’annuaire téléphonique pour expliquer comment appeler des procédures stockées et des fonctions définies par l’utilisateur en passant des paramètres et en capturant les valeurs renvoyées. En apprenant à créer cet exemple d’application, vous serez en mesure de créer des solutions flexibles à base de services Web et d’étendre les possibilités d’utilisation des objets de base de données SQL Server existants. Par ailleurs, certaines organisations pourront voir dans cet exemple une solution rapide et simple d’annuaire téléphonique en ligne s’exécutant derrière un pare-feu.

SQL Server Actualités – Semaine 26 – 2006

Les actualités SQL Server de la semaine du 26 Juin au 2 Juillet 2006

Lire l'article

La synchronisation avec turbocompresseur

par Bren Newman - Mis en ligne le 19/04/2006 - Publié en Février 2005

La gestion d’un système de base de données distribué présente de nombreux défis, dont l’un des plus ardus est le besoin de synchroniser rapidement les mises à jour. La réplication transactionnelle et la réplication de fusion sont des techniques de réplication efficaces bien connues. Mais chacune comporte des limitations et peut restreindre les performances. Si vous éprouvez de la frustration par rapport aux limitations de ces méthodes, vous oubliez peut-être une autre solution : la réplication transactionnelle bidirectionnelle. Dans certains cas, la mise en oeuvre de cette technique procure une solution particulièrement rapide pour la mise à jour de plusieurs sites géographiquement disséminés. Si vous êtes prêt à franchir un certain nombre d’obstacles, l’équipe Microsoft de consultants clients pour le développement SQL Server aide les clients à mettre en place la réplication bidirectionnelle entre autres sur les marchés de la finance, de la bourse et des télécommunications. La plupart de ces clients utilisent cette technologie afin de créer une solution de reporting de base de données qu’ils peuvent convertir rapidement et facilement en site de basculement ou de reprise après sinistre.SQL Server prend en charge cette forme puissante et rapide de réplication transactionnelle depuis la version 7.0. Toutefois, peu d’administrateurs de base de données (DBA) ont connaissance de cette fonctionnalité ou savent exploiter sa puissance, dans une large mesure en raison d’une documentation inappropriée et d’un manque général de compréhension de son fonctionnement. La documentation en ligne de SQL Server 7.0 inclut une section particulièrement réduite sur le sujet et Microsoft a malheureusement omis de traiter cet aspect dans les premières éditions de la documentation en ligne de SQL Server 2000. Depuis, la société de Redmond s’est rattrapée dans la dernière édition de cette documentation, téléchargeable à l’adresse http://www. microsoft.com/sql/techinfo/ productdoc/2000/books.asp.

Le tableau Web 1 (téléchargeable à l’adresse http://www. itpro.fr, Club abonnés) compare les fonctionnalités de quatre méthodes de réplication : la réplication transactionnelle bidirectionnelle, la réplication transactionnelle avec mise à jour en attente, la réplication transactionnelle avec mise à jour immédiate et la réplication de fusion. La majorité des DBA ont recours à la réplication transactionnelle afin de disséminer un flux de transactions journalisées d’une source, l’éditeur (Publisher), vers un ou plusieurs serveurs cible non actualisés et fortement utilisés pour les opérations de lecture (par ex., les serveurs de reporting), appelés abonnés (Subscriber). Les DBA utilisent en général ce type de réplication afin d’augmenter les performances des lectures agrégées. Les abonnements à mise à jour immédiate, introduits par Microsoft dans SQL Server 7.0, permettent aux abonnés de la réplication transactionnelle de modifier les données à leur niveau. Toutefois, ces derniers ne peuvent effectuer cette modification que via une connexion réseau avec l’éditeur (autrement dit, l’abonné doit être en ligne). Dans SQL Server 2000, les abonnés avec mise à jour en attente peuvent modifier les données à leur niveau sans être connectés à l’éditeur. Ces deux méthodes nécessitent l’ajout d’une colonne aux tables utilisateur.

Par ailleurs, elles ne prennent pas en charge la mise à jour de colonnes de texte ou d’images et assurent le suivi des modifications au moyen de déclencheurs générés automatiquement.

Bien que la réplication de fusion (introduite dans SQL Server 7.0) gère la modification des colonnes de texte et d’images, elle utilise aussi des déclencheurs et impose d’ajouter aux tables une colonne spécifique à la réplication et contenant le type de données uniqueidentifier (par ex., un GUID), qui ajoute 16 octets supplémentaires et est globalement unique.

L’ajout de ces déclencheurs et colonnes peut se révéler problématique pour certaines applications et nombre de DBA rechigne à l’employer. Microsoft a mis au point la réplication de fusion spécialement à l’attention des utilisateurs mobiles déconnectés (par ex., les utilisateurs d’applications d’automatisation de la force de vente), proposant des possibilités extensibles de gestion et de suivi des modifications et des conflits, ainsi que des fonctionnalités extrêmement flexibles de partitionnement et de filtrage. Toutefois, pour tirer parti de ces avantages, vous devez vous acc

L’automatisation à la loupe

par Alex Glauberzon et Martin Wiseman - Mis en ligne le 28/06/2006 - Publié en Avril 2005

Prenez le temps de repenser à la dernière fois où vous avez dû mettre à jour une table contenant un grand nombre de colonnes. Imaginez maintenant que cette table est en cours de construction et que vous êtes chargé d’ajouter ou de supprimer des colonnes, ou encore de changer des spécifications de données de colonnes. Naturellement, cette situation se produit alors que votre emploi du temps est des plus serrés et que vous avez d’autres problèmes plus importants à résoudre. Quel casse-tête ! En fait, vous avez la possibilité d’automatiser une solution à ce problème en combinant les possibilités élémentaires des procédures stockées et le dictionnaire de données sous-jacent de SQL Server.Une procédure stockée est un groupe d’instructions T-SQL compilées dans un plan d’exécution. L’utilisation des procédures stockées procure un certain nombre d’avantages. Premièrement, elles permettent à un développeur de réutiliser efficacement le code. Une fois que vous avez créé une procédure stockée et que vous l’avez stockée dans la base de données, toute personne qui peut y accéder est en mesure de l’appeler à volonté, de sorte que vous n’avez pas besoin de réécrire constamment le même code. Le développeur peut ainsi utiliser de manière plus productive le temps dont il dispose. Deuxièmement, les procédures stockées accélèrent l’exécution des requêtes. Dans la mesure où ce type d’élément est précompilé et où SQL Server réutilise le plan d’exécution résultant, cela se traduit par des économies substantielles en termes de temps et d’utilisation globale du processeur. Si une application appelle constamment les mêmes procédures stockées, elle conserve ces dernières en mémoire, d’où un gain de temps supplémentaire, en particulier par rapport au temps nécessaire pour appeler à plusieurs reprises le code T-SQL équivalent. Troisièmement, le recours aux procédures stockées réduit le trafic réseau global. Au lieu de transmettre de nombreuses lignes de code T-SQL, SQL Server transmet uniquement le nom de la procédure appelée, ce qui optimise l’utilisation de la bande passante réseau. Enfin, les procédures stockées améliorent les contrôles de sécurité. Même si les utilisateurs n’ont pas le droit d’accéder à des tables spécifiques, vous pouvez leur attribuer l’autorisation d’exécuter une procédure stockée qui référence les tables en question. Cette méthode de limitation des accès aux tables peut soulager le travail de l’administrateur.

Même si les avantages de l’utilisation des procédures stockées sont appréciables, vous devez malgré tout consacrer le temps et l’énergie nécessaires à leur création. L’écriture de procédures stockées pour les opérations UPDATE, INSERT et DELETE prend du temps et le processus fournit pas mal d’occasions d’introduire des erreurs. Par exemple, une procédure stockée type pour une opération UPDATE contient plusieurs parties :

une instruction CREATE PROCEDURE; une liste de paramètres, qui peut être longue en fonction du nombre de colonnes dans la table ; une instruction UPDATE ; une liste SET, qui identifie la liste de colonnes mises à jour par la procédure et une clause WHERE énumérant les critères spécifiant les lignes mises à jour. De même, une procédure stockée servant à introduire des lignes dans une table comporte les parties suivantes : une instruction

CREATE PROCEDURE ;

une liste de paramètres ;

une instruction INSERT;

une liste de colonnes qui identifie les colonnes insérées par la procédure et une clause VALUES énumérant les critères qui spécifient les lignes insérées. La création d’une procédure stockée de suppression de lignes d’une table est relativement simple : elle requiert uniquement des critères de sélection en tant que paramètres et une clause WHERE afin de limiter le nombr

La magie des lots

par Kirk Haselden - Mis en ligne le 28/06/2006 - Publié en Avril 2005

Dans SQL Server 2005, Microsoft a complètement réécrit les services de transformation de données ou DTS (Data Transformation Services), pour de multiples raisons. Non seulement la nouvelle mouture rationalise les fonctionnalités de DTS et rend cet outil plus simple d’utilisation, mais elle améliore également son évolutivité et ses performances. L’article « Quoi de neuf dans DTS? » (www.itpro.fr) proposait déjà un aperçu des points forts du nouveau DTS, y compris les objectifs de conception et les nouvelles fonctionnalités de DTS Designer (Concepteur DTS).Après la sortie en juillet d’une version bêta privée générale et avec le lancement prochain de la bêta publique de SQL Server 2005, il est temps d’examiner plus en détail certaines améliorations spécifiques de DTS. Comme nombre d’utilisateurs de SQL Server 2005 DTS utilisent principalement ou uniquement l’Import/Export Wizard (Assistant Importation/exportation), commençons par examiner plus avant cet aspect de la question. Bien que l’équipe de développement Microsoft DTS, dont je fais partie, a amélioré et étendu tous les outils de DTS 2005, l’Import/Export Wizard reste un moyen remarquable pour créer rapidement des lots destinés à déplacer les données. La nouvelle version de l’assistant inclut deux changements majeurs. Premièrement, il ne prend plus en charge la copie d’objets entre les bases de données SQL Server. Pour effectuer cette opération, vous allez désormais faire appel au Transfer Database Wizard. Cet assistant est accessible à partir de SQL Server Management Studio, la nouvelle suite de gestion de SQL Server 2005 qui remplace les outils Enterprise Manager, Query Analyzer (Analyseur de requêtes) et d’autres utilitaires. Deuxièmement, le nouvel assistant ne prend plus en charge la création de transformations de scripts.

Pourquoi l’équipe a-t-elle décidé d’apporter ces modifications ? La réponse est toute simple : il fallait recentrer et simplifier l’assistant afin qu’il soit exclusivement un outil de déplacement de données et non un outil d’extraction, de transformation et de chargement (ETL). L’expérience a montré que l’existence de la fonctionnalité de copie d’objets en deux emplacements, à savoir dans le DTS Import/Export Wizard et dans le Copy Database Wizard (Assistant Copie de base de données), entraînait parfois une certaine confusion pour les utilisateurs. Afin d’éliminer cette fonctionnalité en double, nous avons consolidé les fonctions de copie dans le Copy Database Wizard. Ce changement devrait clarifier le rôle des différents outils. Si vous souhaitez créer rapidement des lots afin de déplacer des données, utilisez l’Import/ Export Wizard. Pour déplacer des objets de base de données (allant de bases de données complètes à quelques éléments d’une base de données), vous allez employer le Transfert Database Wizard. Enfin, la création de lots effectuant des transformations simples ou complexes sur les données à des vitesses de transfert élevées est dévolue à DTS Designer.

Bien que nous ayons simplifié le DTS Import/ Export Wizard, cet outil demeure relativement complexe et souple. En fonction des paramètres et options sélectionnés, les possibilités de cheminement à travers l’assistant sont multiples et cet article ne pourra donc pas couvrir tous les paramètres disponibles. Par conséquent, en s’appuyant sur la création d’un lot d’importation de données simple dans l’Import/Export Wizard, nous allons mettre en exergue les fonctionnalités qui se démarquent de la version utilisée dans DTS 2000. Dans un prochain article, nous irons dans les coulisses et examinerons le travail de l’assistant en affichant et modifiant le lot résultant dans DTS Designer.

MS Analysis : hors des sentiers battus : partie 2

par Lionel Billon - Mis en ligne le 05/04/2006 - Publié en Février 2005

Outre les membres calculés, MS Analysis Services propose plusieurs mécanismes sophistiqués pour que vous puissiez surcharger les agrégations d’un cube. Dans le précédent article, nous avions parlé des Custom Members. A présent, nous allons aborder la notion de “Custom Rollup” et de Cellules calculées.Les notions de Membres calculés, Custom Member, “Custom Rollup” et Cellules calculées ont des points communs : elles permettent de surcharger les agrégations du cube et sont définis en MDX. Elles ont également des différences, dont voici un bref rappel :

- Le Membre Calculé est associé à une dimension, il permet d’ajouter un calcul MDX matérialisé sous forme d’un nouveau membre de cette dimension.

- Le Custom Member est lui aussi associé à une dimension. Il permet cependant d’externaliser le calcul MDX d’un membre calculé classique au sein d’une table relationnelle. L’avantage par rapport au membre calculé est donc de pouvoir bénéficier automatiquement de ce calcul dans l’ensemble des cubes utilisant la dimension hôte du "custom member", sans redéfinir le calcul. (Ce qui facilite grandement les tâches d’administration).

- Le “Custom Rollup” est également associé à une dimension, plus précisément à un niveau d’une dimension. Il s’applique à tous les membres du niveau sur lequel il est appliqué à l’exception des membres calculés. Tout comme le Custom Member, le “Custom Rollup” est réagrégé automatiquement.

- La Cellule Calculée est sans doute l’outil le moins connu et le moins utilisé de MS Analysis Services. Souple et versatile, la Cellule Calculée permet de définir un calcul s’appliquant à un sous ensemble de cube (tranche de cube) sans création de membre supplémentaire. La Cellule Calculée vient tout simplement remplacer la valeur affichée dans les cellules du cube comprises dans la tranche qu’elle couvre. Si les membres calculés peuvent être, dans une certaine mesure, récursifs, les cellules calculées sont les seules à pouvoir être exécutées plusieurs fois tout en pouvant accéder aux valeurs obtenues lors des passes précédentes. Ce qui peut être fort utile pour les calculs itératifs de type « Goal Seeking ». (Par exemple, dans l’utilisation d’un calcul cherchant le pourcentage de rétribution optimal pour les commerciaux. Le calcul pourrait évaluer plusieurs scénarios : Un premier test pourrait être effectué avec une rétribution de 10%, cependant si après rétribution la rentabilité n’est plus conforme aux objectifs, le calcul pourrait tester une rétribution de 5% et si nécessaire baisser la rétribution à 3%.)

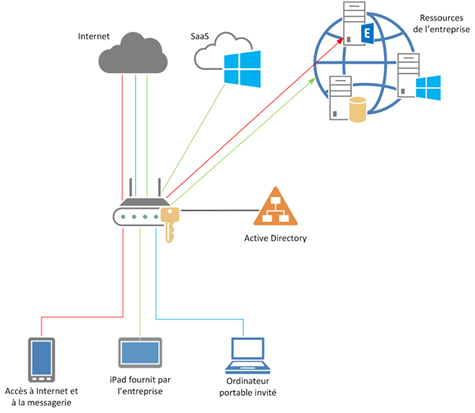

Synchronisation à la demande

par Gary Zaika - Mis en ligne le 05/04/2006 - Publié en Février 2005

Après l’attaque du World Trade Center, le 11 septembre 2001, nombre d’organisations ont reconsidéré leur approche de la gestion et de la protection des données d’entreprise stratégiques. La mise en place d’un centre de traitement distant avec un deuxième ensemble de bases de données et de serveurs d’applications est devenue une pratique courante. Les entreprises ont accepté de supporter le coût du personnel et des centres de traitement supplémentaires, ainsi que des modifications dans la conception des applications afin de pouvoir basculer les opérations rapidement vers un autre emplacement en cas de sinistre. Par exemple, après les attaques du 11 septembre, une grande banque pour laquelle j’ai travaillé récemment comme consultant Microsoft Consulting Services a commencé à demander la configuration suivante, à savoir la possibilité d’exécuter toutes les applications cruciales à partir de l’un ou l’autre de deux sites distants de plusieurs centaines de kilomètres, sans induire une interruption du fonctionnement supérieure à 2 heures.Ces exigences économiques plus strictes constituent un défi pour les architectes de bases de données. La majorité des bases de données des organisations ne cessent de croître, mais les fenêtres admissibles pour la maintenance et les interruptions de fonctionnement sont réduites au minimum. Les bases de données doivent offrir une disponibilité maximale et être prêtes à fonctionner dans des environnements distribués, et les données des bases de données principales (l’éditeur ou publisher) et secondaires (l’abonné ou subscriber) doivent rester synchronisées en permanence.

Plusieurs solutions prennent en charge la haute disponibilité pour les bases de données SQL Server 2000 réparties sur différents sites, notamment l’envoi des journaux, les solutions matérielles et logicielles tierce partie telles que les clusters géographiques ou la solution de réplication distante du stockage SRDF d’EMC, ou encore la réplication transactionnelle. Dans la plupart des solutions de haute disponibilité, l’abonné est partiellement ou complètement indisponible pendant la synchronisation des données. Par exemple, dans le cas de l’envoi des journaux, la base de données de l’abonné est accessible en lecture seule uniquement si aucun nouveau journal des transactions n’est appliqué. Avec la solution matérielle SRDF onéreuse, la base de données de l’abonné n’est jamais disponible ; elle ne le devient que pour la restauration des données en cas d’arrêt de la base de données de l’éditeur. Seule la réplication transactionnelle permet d’utiliser pleinement la base de données de l’abonné en permanence. Cette solution est disponible dans toutes les éditions de SQL Server, d’où la possibilité d’éviter les dépenses supplémentaires liées à l’achat de logiciels tierce partie, tout en exploitant au maximum les plates-formes matérielles en place. C’est la raison pour laquelle de nombreuses entreprises ont retenu la réplication transactionnelle comme solution de haute disponibilité.

Néanmoins, cette approche ne résout pas automatiquement le problème de la synchronisation des données. La mise en place et la gestion de cette solution requiert des processus métier performants et une équipe de DBA particulièrement compétents. Nous allons, dans cet article, examiner le problème de disponibilité élevée auquel la banque pour laquelle j’ai travaillé a été confrontée lors de la mise en oeuvre de la réplication transactionnelle et de la synchronisation permanente des données. Nous verrons également comment j’ai résolu le problème en employant une nouvelle méthode que j’ai appelée « réplication forcée ».

Les plus consultés sur iTPro.fr

- L’IA dans l’entreprise : questions et pratiques contemporaines

- Être une femme dans la tech en 2025 : comment prendre sa place et évoluer ?

- Les différents types de cyberattaques les plus répandues

- Bilan 2024 de la start-up Nation

- DORA, vecteur d’accélération de la transformation numérique des assureurs